Es un negocio grande, la industria analítica. Parece que, hoy en día, puedes encontrar una empresa ofreciendo análisis de “Big Data” debajo de cada piedra, lo cual no debería ser sorprendente dada la importancia que la mayoría de las compañías modernas le dan a analizar los números. Sin embargo, basándome en mi experiencia trabajando con organizaciones que han sucumbido al deseo de explorar su data, argumentaría que muy pocos saben qué hacer con eso una vez que lo han implementado. Si todavía no han desembolsado bastante dinero en un “científico de datos” (quienes, la mayoría de las veces, se pueden encontrar sentados en un rincón esperando preguntas que nadie realmente sabe cómo hacer), entonces el “análisis” es con frecuencia algo que se le tira al Millennial más joven de la oficina con la idea de que probablemente “aprendieron esas pavadas de Google en la escuela”.

“¿Alguna vez te preguntaste como se ve una carrera hacia el abismo? Sentalo a un editor, o a un periodista, delante de una pantalla de análisis en tiempo real y observa su reacción.”

En el mundo editorial, una confusión general alrededor de los datos, el análisis y sus usos parecen estar particularmente extendidos. En las oficinas de redacción levantan pantallas masivas mostrando el análisis en tiempo real, cebados para perseguir navegantes y otras métricas simples por cualquier hueco que puedan descubrir. Los editores se encuentran estudiando hojas de cálculo, desesperados por encontrar algo — cualquier cosa — que se parezca a una pista para dar en el blanco. Si alguna vez te preguntaste a que se parece una carrera hacia el abismo, sienta a un editor o a un periodista delante de una pantalla con análisis en tiempo real y observa su reacción.

Hay por lo menos dos problemas aquí: en primer lugar, los editores son fundamentalmente narradores más que analistas de datos, y en segundo lugar, que — hasta hace poco- los paquetes analíticos en oferta nunca estuvieron destinados para uso editorial, operando en su lugar con métricas simples (páginas vistas, tiempo de permanencia, y otras datos que solo apuntan a partes aisladas de la historia en general) que fueron desarrolladas más que nada para vendedores. El escenario frustrante con que nos quedamos es un editor famélico de tiempo volcándose sobre una pantalla de Análisis de Google que fue creada pensando en el marketing.

Habiendo gastado varios años trabajando inicialmente como uno de esos editores frustrados, y luego en una de las primeras compañías en ofrecer un paquete de análisis verdaderamente enfocado en lo editorial, me he preguntado frecuentemente: ¿cómo llegamos hasta acá y por qué nuestra industria está tan atrasada? Así que decidí explorar un poco.

Las tres eras del análisis

Si bien se puede argumentar que las personas han estado midiendo y analizando cosas desde que Pedro Picapiedra y Pablo Mármol competían por la velocidad de sus vehículos motorizados a pie, el análisis de datos con respecto al negocio moderno comenzó a evolucionar en la primera parte del siglo XX. Thomas Davenport, del Instituto Internacional de Análisis, reconoce tres Eras distintivas y, como veremos, tendrías que preguntarte si él tenía alguna idea de que la analítica editorial siquiera existía. Mientras que él ve a la mayoría de los negocios relacionados con el análisis yendo a un futuro feliz, por lo menos algunos de ustedes reconocerán que el mundo editorial está parcialmente atascado en alguna parte del pasado.

1.0 Analíticas Tradicionales

Davenport cree que los primeros de éstos se volvieron reconocibles a mediados de los años 50 y se desvanecieron en la primera parte del nuevo milenio. Para mucha gente trabajando en editorial en 2017, algo de lo que él describe sobre los primeros días va a sonar alarmantemente familiar. Él explica que “los analistas eran puestos en ‘cuartos traseros’, segregados de la gente de negocios y de las decisiones”, que “pocas organizaciones ‘competían en analíticas’ — las analíticas eran marginales para la estrategia”, y que “las decisiones eran tomadas basadas en la experiencia e intuición”. Por supuesto, las decisiones editoriales aún tienen que ser tomadas con experiencia e instinto por sobre todo, pero está claro que, para muchos editores, el análisis todavía ocupa un rol un poco más que “marginal” en la elaboración de estrategias, generalmente porque los analistas permanecen — mentalmente, quizás, antes que físicamente — “en cuartos traseros”.

Davenport continua, explicando que en los primeros días, “la mayor parte de la actividad analítica eran análisis descriptivos o informes”. Editores de cierta edad sabrán que, hasta hace poco, este era el caso en nuestra industria. Las analíticas editoriales siempre han existido en el sentido más básico — no encontrarás un editor en la historia que no haya tenido una idea razonable de sus cifras de ventas. Y si las cifras de ventas eran las páginas vistas de su día (por lo que quiero decir datos que carecen de detalles y que son algo engañosos), por lo menos teníamos grupos de sondeo y cartas al editor para darnos alguna idea de cómo estábamos siendo recibidos. Algunos de nosotros todavía los tenemos. En efecto, uno podría argumentar que las analíticas editoriales en realidad precedieron los esfuerzos analíticos que Davenport está observando aquí, y que existe evidencia de grupos de sondeos en acción editorial que se remontan a los años 20 del siglo pasado como una forma de investigación del mercado y como una forma de desarrollo de técnicas de propaganda durante la Segunda Guerra Mundial.

El carácter distintivo del 1.0 era aparentemente, “interno, esmerado, de mirada retrógrada y lento”. En esto, no estoy seguro de que hayamos avanzado mucho. ¿Interno?, sí. ¿Esmerado? Doble sí. ¿Lento?

Indudablemente, darle sentido a las analíticas editoriales va mucho más lento de lo que debería ser. Sólo “retrógrado” parece fuera de lugar. Hoy en día tenemos una tendencia de saltar sobre cualquier cosa que dice ser en “tiempo-real”, que yo sospecho es, en parte, porque nos gusta que nos masajeen el ego (“fíjate cuanta gente está leyendo mi artículo”) y, en parte, porque parece evitarnos indagar mucho más (“¡tengo medio millón de páginas vistas! ¿Qué más quieres?”). Por supuesto, esto nos deja en un círculo vicioso.

Terminamos en la muy difamada cámara de ecos cuando nos despreocupamos, y repetimos sin siquiera preguntarnos qué es lo que estamos haciendo. Dicho todo esto, en las analíticas editoriales la mirada retrógrada no es un crimen tan grande si usas el término literalmente: mirar hacia atrás a lo que hiciste es algo bueno; aprende de las tendencias que tu análisis editorial arroja en lugar de tratar de ser el Gardel del tiempo-real.

“Tenemos una tendencia hoy en día de saltar sobre cualquier cosa que dice ser en “tiempo-real”, que yo sospecho es, en parte, porque nos gusta que nos masajeen el ego.”

Otros puntos en la descripción de Davenport de 1.0 que todavía suenan verdaderos incluyen, “Tómate tu tiempo — de todas formas nadie está tan interesado en tus resultados”, y “si es posible, gasta mucho más tiempo alistando los datos para el análisis que realmente analizándolos”. Perdí la cuenta de la cantidad de veces que he visto una empresa gastar una buena cantidad de dinero en un analista de datos solo para luego darse cuenta que su empleo es un ejemplo de “lo hago porque todos lo hacen”. Muchos editores me dicen, más que nada (y comprensiblemente) extraoficialmente, que ellos no están realmente seguros de qué preguntas hacer sobre sus datos, no entienden realmente lo que se les está mostrando, y no están completamente seguros, de cualquier forma, de cómo accionar los resultados. Así que el analista se esfuerza, preguntándose para qué, exactamente como lo hacían hace 50 o 60 años. ¡Para una industria que se enorgullece por ser la primera con la noticia, estamos muy atrasados en el tiempo en muchas áreas!

2.0 Big Data

Mientras que el término “Big Data” se acuñó alrededor del año 2010, el interés, para muchas industrias, en lo que se podría cosechar digitalmente y como se podrían usar esos datos va un poco más atrás. Por ejemplo, Google Analytics empezó a funcionar como Urchin, cuyo código fue escrito alrededor de 1997.

Se convirtió en Google Analytics en 2005 y, a partir de 2015, estaba siendo utilizado por algo más de las mitad de los sitios web del mundo (con un 83,4% de la acción del mercado analítico). Una vez más, en mi experiencia, aquellos que utilizan Google Analytics más efectivamente tienden a ser aquellos con algo tangible para vender — una venta al final de un canal que se puede predecir, rastrear y reportar — y, a riesgo de repetirme, esto es para lo que se creó la herramienta. Sin embargo, con su plétora de campanas y silbatos de métrica simple, es extremadamente engañoso para el editor moderno, ofreciendo muy poco algo que pueda apuntar a la participación o comportamiento genuino del lector. Y, a pesar de todo, ahí está — la herramienta de análisis más comúnmente utilizada (y mal entendida) en la industria.

Este período también coincide con la explosión de las redes sociales — plataformas que se construyeron sobre algoritmos que requieren de datos para que puedan trabajar con eficacia. Este fue un punto crucial en la evolución de la analítica por una serie de razones. En primer lugar, porque cada vez más usábamos sistemas que se alimentaban de datos instantáneos en lugar de hojas de cálculo analizadas por humanos y, en segundo lugar, porque hacían que los datos fueran “sexy”. En las redes sociales, los datos que rodean tu propio perfil tenían un efecto directo sobre cómo te sentías. Es en donde vemos los comienzos de esa tendencia de auto gratificación y preocupación por el tiempo real que mencioné anteriormente, y donde empiezas a ver el surgimiento de cosas como Klout y de otras mediciones de éxito similares basadas en cantidad de seguidores. Esto dio lugar a un universo alternativo que pocos de nosotros podríamos haber imaginado, en el que las situaciones bizarras y la obsesión con el Yo se convirtieron en la norma, como esta…

Para la mayoría de las personas “normales”, la repentina realización de que de alguna manera podrías medir tu propia popularidad (aunque dudosa) marcó la primera vez que las estadísticas y la analítica habían entrado en sus vidas de una manera emocionante. Tu maestra siempre te dijo que algún día las matemáticas te serían útiles, pero nunca insinuó que podrían tener un efecto positivo en tus niveles de dopamina. Y las empresas se dieron cuenta de esto, también. Como señala Davenport, Big Data, la analítica y la forma en que el consumidor podría ponerlas en marcha e influenciarlas, “no sólo informaron decisiones internas en esas organizaciones, sino que también formaron la base para productos, servicios y características orientados al cliente”.

“Tu maestra siempre te dijo que algún día las matemáticas te serían útiles, pero nunca insinuó que podrían tener un efecto positivo en tus niveles de dopamina.”

Nuevamente, tomó algo de tiempo para que esto se filtre hacia abajo en la industria editorial, y cuando lo hizo, al principio llegó en forma de widgets con los artículos “más populares” — alimentando, una vez más, en el más ruin de las métricas — páginas vistas — antes que cualquier cosa que podría realmente llamarse una indicación genuina de compromiso exitoso. Y, en cierto punto, es ahí donde estamos atascados. Si bien sería injusto decir que no hemos hecho nada útil desde el lado de los datos que utilizamos (estoy pensando específicamente en los algoritmos de personalización y la capacidad de alimentar al lector con lo que nosotros creemos que podría apreciar más), para la mayoría de los periodistas en la sala de redacción, los datos aún comienzan y terminan con sus vistas de página, en tiempo real o de otra manera.

Mientras tanto, otras industrias dependientes de datos avanzaron. “Había un alto grado de impaciencia”, dice Davenport. “Un ejecutivo (CEO) de Big Data dijo:” Hemos probado ágiles [métodos de desarrollo], pero fue demasiado lento. “La industria de Big Data fue vista como una ‘apropiación de tierras’ y las compañías buscaron adquirir clientes y capacidades muy rápidamente”. A Los geeks de los datos se les permitió salir de sus habitaciones traseras, se les aumentó el sueldo y se los aclamó como “científicos de datos”. La palabra “algoritmo” entró en el lenguaje del hombre común. Esos fueron días de optimismo desenfrenado.

Para no quedar totalmente atrás, en la industria editorial, también, las cosas comenzaron a parecerse al Lejano Oeste. Las startups de datos basados en la nube aparecieron alegando tener las respuestas que todos estábamos buscando. Pero, de nuevo, teníamos las preguntas todas equivocadas. Las herramientas que se ofrecían dependían en gran medida en la misma vieja métrica única, o, alternativamente, nos alentaban a poner el foco sólo en nuestro desempeño en las redes sociales.

Se le dio mucha importancia al ubicuo ‘me gusta’, con pocas personas parándose a preguntarse qué significaba eso. ¿Tienes 567 me gusta? ¡Estupendo! Se parece a la aprobación, pero ¿se parece en algo a un compromiso genuino?, ¿Qué significa eso?, ¿Qué pasó después?, ¿Alguien realmente leyó algo?. Twitter comenzó a promocionar el alcance de la audiencia y las impresiones de páginas y todo el mundo enloqueció con el mero tamaño de sus números. ¿Dos millones de impresiones de páginas? ¡Gol! Pero, ¿qué es una impresión de página? ¿Realmente tienes alguna idea de lo que estás hablando…?

Extraordinariamente, se tardó hasta 2016 antes de que alguien desentierre cualquier información seria sobre cómo las acciones de Facebook invariablemente conducen a cero compromiso de los lectores. En este punto, sin embargo, algunos de nosotros habíamos comenzado a sospechar que algo estaba en marcha; que las analíticas que estábamos utilizando estaban creando malos hábitos al mismo tiempo que revelaban cosas sin valor.

3.0 Impacto Rapido Para La Economia De Datos

La tercera de las eras de datos de Davenport es donde nos encontramos ahora, sólo que es fácil ver con una breve mirada que la industria editorial — capaz de implementar los modelos de Big Data como cualquier otro — tiene que ponerse al día.

Davenport habla de un uso rápido e integral de los datos en los niveles más altos, impulsando la toma de decisiones dentro de las organizaciones, sin embargo en las salas de redacción de todo el mundo vemos editores luchando por encontrar el tiempo para hacer los trabajos para los que fueron capacitados, y menos aún tirarse de cabeza a un informe de analíticas. Y, como ya hemos visto, hay muchos que no están seguros acerca de cómo deben implementar sus informes, incluso cuando logran encontrar cinco minutos para estudiarlos.

También habla de múltiples tipos de datos a menudo combinados, pero aquí la mayoría de nosotros todavía estamos esclavizados a herramientas analíticas que fomentan la dependencia de información engañosa. (Locamente, muchas personas en la industria parecen ser conscientes de esto, pero hacen muy poco para cambiar ese comportamiento. ¿No es una de las definiciones de locura el saber que estás equivocado pero sigues haciendo lo mismo una y otra vez?).

Hasta muy recientemente, pocas personas le habían prestado atención a la posibilidad de separar los grupos de datos y crear algo que comparase y analizara cómo se relacionan entre sí. En una conferencia de la WAN-IFRA en noviembre de 2016, Kritsanarat Khunkham de Die Welt habló sobre el desarrollo de una “puntuación del artículo” que se relaciona de alguna manera con esto, y justo la semana pasada Marc Prichard de Procter & Gamble le pidió al mundo del anuncio que “madure” y comience a usar “métricas de verificación estándar del sector”.

Ambos son grandes pasos hacia adelante en la dirección correcta (especialmente para los miembros de la industria publicitaria, que han estado tapándose los ojos los unos a los otros durante demasiado tiempo), y que coinciden con la llegada a la mayoría de edad del Indicador de Desempeño del Contenido (o CPI, por sus siglas en Inglés), el corazón de una herramienta de indicación innovadora desarrollada por Content Insights, que ofrece precisamente lo que estas personas están empezando a notar que les falta, y que está siendo rápidamente adoptada por algunos de los principales editores de Europa.

Todo esto no quiere decir que debemos renunciar y abandonar la nave. Sin embargo, mientras que Thomas Davenport representa el mundo de negocios haciendo tictac junto al sonido de los datos que están siendo cultivados exitosamente, el editor de Boston Globe, Brian McGrory, dio en el clavo en un reciente correo electrónico cuando dijo: “Estamos nadando en métricas. El objetivo ahora es refinarlos, interpretarlos y aplicarlos “. Encontrar una manera de manejar esto es el Santo Grial para la mayoría de la gente en su nivel de dirección.

Entonces, ¿dónde estamos ahora, y qué sigue para la analítica editorial?

Si bien este artículo se puede leer un poco como el informe de un estudiante errante (“¡debe hacerlo mejor!”), estamos en realidad en un lugar razonablemente prometedor. Como señalé anteriormente, las figuras clave en la industria están empezando a pedir un entendimiento más maduro que traiga un estándar a la forma en la que abordamos el análisis como industria. Nos ha llevado un tiempo llegar a este punto, y algunos de nosotros hemos estado pidiendo una mejora por varios años, pero ya estamos llegando allí. Cada vez más de nosotros estamos empezando a entender lo que se necesita, y en Content Insights ya estamos de alguna manera por ese camino.

En breve:

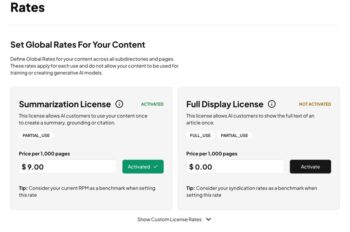

- Es hora de que reconozcamos que muchas de las herramientas que estamos usando para medir el desempeño de nuestro contenido fueron desarrolladas para vendedores. Si vamos a tomar la analítica editorial en serio, tenemos que volver a calibrar cómo nos acercamos a nuestros datos y hacer uso de las herramientas que se crean pensando en lo editorial.

- La industria editorial necesita hacerse completamente a la idea de que las métricas simples por sí solas no nos dirán mucho. En cambio, debemos apuntar a métricas evaluadas que comprendan cómo se relacionan entre sí las líneas de datos que recopilamos.

- Los editores deben admitir más fácilmente que tener acceso a los datos no es suficiente. Necesitamos saber qué preguntas hacer a los datos que recopilamos, entender mejor que significa y cómo podemos implementarlo para mejorar el rendimiento, de lo contrario el poco tiempo que tenemos de sobra está siendo desperdiciado.

- Así como necesitamos alejarnos de las métricas simples, necesitamos reconocer cuándo están jugando nuestros niveles de dopamina. Los datos en tiempo real son una cosa maravillosa para partes de la redacción, específicamente las partes que tratan con el diseño de la página principal en tiempo real y sacando hasta el último clic de tus potenciales lectores -pero no te dice nada acerca de cómo tu audiencia lee los artículos, o incluso cómo construir tu éxito.

- Muchos de nosotros hemos sabido todo esto por bastante tiempo. ¿No es hora de que actuemos juntos en lugar de quedarnos sentados pensando? Hasta que no empecemos a mirar estas cosas como una industria, me parece que nuestra propia Era 3.0 sigue estando un poco lejos.